|

云与超算规模的管理挑战

高性能计算作为实验和理论以外的第三大科学研究手段,越来越受到重视。高性能计算甚至在一定程度上反映了综合国力发展水平,各国都投入巨资建造大型超级计算机,TOP 500的记录不断被刷新。但是超算规模的增加,也给高性能计算的系统管理带来了新的挑战。

1. 在固定资源情况下,多用户使用的高性能计算系统作业调度追求系统利用率和用户服务质量平衡,但很难同时保证,比如短作业等待时间的调度目标将导致低利用率,而高利用率的调度目标有可能增加用户作业的等待时间。

2. 随着高性能计算应用的普及,各种应用从底层操作系统、到并行计算中间件(如MPI)以及上层的应用软件都各不相同,对于计算、网络和存储等物理层硬件的要求也不尽相同,比如高性能计算还可以再细分为计算密集型、吞吐密集型和数据密集型等应用,作业调度如何考虑这些约束因素?

3. 高性能计算的体系架构也在不断演进,GPU和众核异构体系加速了计算性能的提升,但也使得高性能计算的作业调度变得更加复杂。

云计算是一种全新的服务交付模式,允许用户以服务的方式从服务提供商那里获得应用程序、开发环境、硬件平台、虚拟/物理服务器等资源。所有这些服务是按需使用的,用户只需要为已经使用或正在使用的资源付费。其中虚拟化技术是云计算中的一项关键技术,虚拟化技术也可以将一个物理设备抽象成多个逻辑设备。这种模式可以将计算和其他资源分配变得更加灵活、更加可靠、更加容易扩展和升级。

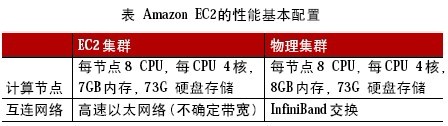

云计算这种灵活的弹性应用模式将为解决上述高性能计算的系统管理带来新的机遇。自云计算兴起以来,一个有趣的问题一直备受关注,即是否能在商业的云计算服务上实现高性能计算。美国德州大学Austin分校的研究人员比较了Amazon EC2计算节点组成的虚拟集群和一个物理集群的性能,基本配置如下表:

他们通过各种典型的并行测试集发现,对于基于OpenMP的共享内存并行程序,EC2集群的性能大约下降了7%~21%,而基于MPI的分布内存并行程序,EC2集群的性能大约下降了40%~1000%,性能下降的主要原因是虚拟化和互连网络导致。虚拟化是高性能计算的一大制约因素,除了导致性能下降以外,有些硬件设备如:GPU和Infiniband根本就无法虚拟化。

此外,为了追求更大的计算容量和能力,可能不能靠单一超算中心的资源去满足,需要跨域调度多个超算中心的资源,网格计算较好地解决了这一问题。但多个云之间的跨域互操作,标准尚未形成,基本还停留在概念中。

我们提出了一种融合高性能计算、网格计算和云计算的新型计算框架——高性能弹性计算(HPEC),可以跨域管理和调度多个云计算资源,支持GPU和众核异构计算环境,用户可以自主灵活地申请和管理计算、存储和网络资源,这些资源可以是虚拟化的或者是直接的物理资源,支持High Performance Computing Platform as a Service(HPCPaaS)多节点集群及上层软件的快速部署,同时支持计算密集(MPI)和数据密集(Map/Reduce)应用等。

本文将总结国内外相关研究和应用进展,探讨HPEC的体系架构和关键技术挑战,最后简要介绍上海交通大学网络与信息中心在HPEC方面的初步研究工作。

国内外相关进展

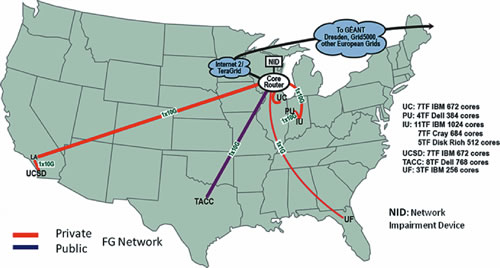

FutureGrid计划是一个网格/云/高性能计算的混合试验床,由NSF支持,它通过万兆高速网络互联了美国和欧洲主要从事高性能计算的大学/中心,如图1所示。

图1 未来网格(Future Grid)

它的主要目标是支撑学术界和工业界开展云/网格/高性能计算和应用的研究,可以给用户提供一个灵活的开发和测试平台,用以评估云/网格计算相关的开源软件的互操作、功能以及性能,体系结构研究包括认证、授权、调度、虚拟化、中间件和接口等,应用研究包括天文、化学、生物、工程和气候等,这些试验可以运行在虚拟机上或者若干台物理机组成的虚拟集群,用户可以通过自主定制软件镜像,快速部署计算环境。

澳大利亚Melburne大学R. Buyyad教授研究组,提出过一个基于.Net技术的高性能云计算软件平台Aneka,并讨论了Aneka在混合云上的部署方案。Amazon在其EC2上也提供了高性能计算服务,但基于硬件虚拟化技术。IBM正在研发一款云计算中HPC的管理套件,可以支持物理机集群,具有自助服务的Web接口,实现快速镜像无盘部署,动态管理物理机和虚拟机资源。

Mircosoft在Windows Azure云上,部署了美国国家基因信息中心的基因比对高性能计算工具BLAST。

体系架构和技术挑战

图2显示了高性能弹性计算的体系架构,从本质上讲,这个架构是从云计算体系架构演化而来,但有以下一些区别:

1. 云计算中的计算资源往往是以虚拟机方式呈现,而高性能弹性计算有时可能是没有虚拟化物理机。这是高性能弹性计算中最大的技术挑战。云计算虚拟机管理器Hypervisor的控制权限仍在云管理者手中,即使将虚拟机的根用户口令给使用者,云管理者可以根据云资源租用合约随时收回分配的虚拟资源。而在无虚拟化的物理资源上,如何能保证云管理者依然能收回分配的资源?

2. 镜像管理。除了提供一般操作系统的标准模板外,还应该允许用户自己创建镜像,包括中间件和应用软件的安装,以及镜像俘获和重用,这是与云计算体系所不同的地方。

3. 动态部署。高性能弹性计算一般都是以虚拟集群方式提供资源,因此要求能够快速地部署多台服务器,通常数量为几十至上百台。

4. 资源监控。监控各种资源的使用情况,为调度管理提供依据。

5. 调度管理是高性能弹性计算中最复杂的部分,它包括云计算中虚拟集群的资源分配、虚拟机/物理机的迁移和虚拟集群的动态资源调整,在每个虚拟集群中的作业调度等。

6. 安全控制可以沿用云计算模式的安全访问控制,通过ACL和VLAN来控制不同试验间隔离,以及用户口令来设定不同权限。

7. 用户试验管理包括多租户管理,试验虚拟集群总资源的设定,用户访问门户等。

验证平台

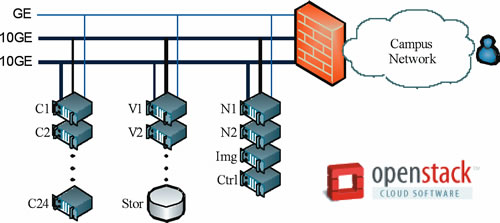

为了验证高性能弹性计算的思想,我们建立了一个验证平台,如图3 所示。Ia aS 我们采用开源软件OpenStack搭建,可以提供类似Amazon的EC2和S3的服务。IaaS平台由24个计算节点(IBM dx360 M3,双路X5650@2.66GHz CPU,96G 内存),存储96TB NAS系统,镜像节点配置了512GB的SSD,完成快速的镜像部署,所有节点采用6 台BNT G8142E万兆以太网交换机互连,此外存储节点S1和S2可以完成类似Amazon EBS的弹性块存储服务,网络节点N1和N2完成DHCP和VLAN管理,所有资源的调度由控制节点完成,控制管理网络采用千兆网络互连,如图4所示。授权用户可以通过校园网访问,申请动态的服务器和存储资源。

图4 验证平台的硬件环境

在IaaS之上,我们部署了MPI、MongoDB(NoSQL数据库)、Hadoop(Map/Reduce开源软件),同时开展系统日志分析数据和计算流体力学应用。同时,我们还在进一步开发监控、调度、管理和认证功能,为未来在全校范围提供高性能弹性服务做准备。

该方案结合云计算技术,提出了一种新型高性能弹性计算框架,该框架具有资源灵活分配的优点,增加了资源利用效率,可以同时动态容纳多个不同类型的高性能计算应用,特别适合校级或者更大规模的超算中心运行管理。

|